도시바의 기존 제품 대비 효율성은 4배, 속도는 10배 끌어올린 딥러닝 가속기를 구현한 제품이다. 지난 2월 19일 미국 샌프란시스코에서 개최된 2019 국제고체회로설계학회에서 세부적인 기술 정보를 공개한 바 있다.

자동 긴급 제동을 비롯한 첨단 운전자 보조 시스템은 더욱 고도화된 기능을 제공하고, 이러한 기능을 구현하려면 이미지 인식 SoC가 필요하다. 이미지 인식 SoC는 전력 소모량은 낮추되 빠른 속도로 도로 교통 표지와 도로 상황을 인식한다.

뇌의 신경망을 본떠 설계한 알고리즘인 심층신경망은 전통적인 패턴 인식이나 머신 러닝보다 훨씬 더 정확하게 인식 프로세스를 처리하기 때문에 자동차 애플리케이션 분야에서 활용도가 높을 것으로 기대를 모은다. 그러나 기존 프로세서로 DNN 기반 이미지 인식을 시행하면 시간이 걸린다. 방대한 양의 MAC을 계산하기 때문이다. 기존 프로세서를 통한 DNN 이미지 인식은 시간뿐만 아니라 전력 소모량도 높다.

도시바는 하드웨어에 딥러닝을 구현한 DNN 가속기를 통해 이러한 문제를 극복했다. 도시바가 개발한 이미지 인식 SoC의 3가지 특징은 다음과 같다.

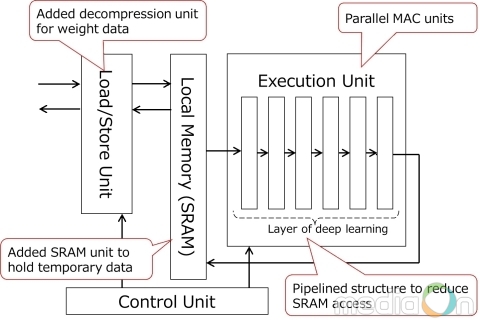

· MAC 유닛 병렬 배치. DNN 프로세싱은 많은 MAC 계산을 요구한다. 도시바의 이미지 인식 SoC는 256 MAC 프로세서 4개를 탑재했다. 이를 통해 DNN 프로세싱 속도를 끌어올렸다.

· DRAM 접속 축소. 기존 SoC는 로컬 메모리가 없어서 DNN 처리 장치에 근접한 시간 데이터를 유지하지 못하고, 로컬 메모리 접속 시 전력을 많이 소모한다. MAC 계산에 필요한 대용량 데이터를 로딩할 때도 전력 소모가 크다. 도시바의 이미지 인식 SoC에 탑재된 SRAM은 DNN 처리 장치에 가깝게 구현되고, DNN 프로세싱이 서브-프로세싱 블록으로 나뉘어져 있어 시간 데이터를 SRAM에 유지한다. 따라서 DRAM 접속을 줄인다. 도시바는 가속기에 압축해제 장치도 추가했다. 사전에 DRAM에 저장·압축된 대용량 데이터는 압축해제 장치를 거쳐 로딩된다. 이런 방식으로 DRAM에서 대용량 데이터를 로딩할 때 발생하는 전력 소모량을 줄인다.

· SRAM 접속 축소. 기존의 딥러닝은 각각의 DNN 레이어를 처리한 후 SRAM에 접속해야 한다. 전력 소모를 키우는 요인이다. 도시바의 딥러닝 가속기는 DNN의 DNN 처리 장치에 파이프라인 레이어 구조를 구축했다. 따라서 한 번의 SRAM 접속으로 일련의 DNN 계산을 실행할 수 있다.

새로운 SoC는 자동차 애플리케이션 기능 안전성의 국제표준인 ISO26262를 준수한다.

도시바는 이미지 인식 SoC의 프로세싱 속도 및 전력 효율성 개선에 매진하고, 차세대 이미지 인식 프로세서인 ViscontiTM5의 샘플을 올해 9월부터 출하할 계획이다.

주

[1] 2015년에 개최된 ISSCC에서 발표한 논문 ‘이미지 인식 애플리케이션용 색상-기반 사물 분류 가속기를 탑재한 1.9TOPS 및 564GOPS/W 이종 멀티코어 SoC’의 도시바 이미지 인식 SoC

- ViscontiTM은 도시바 일렉트로닉 디바이스 앤 스토리지 코퍼레이션의 상표이다.

- 다른 모든 회사, 제품, 서비스명은 각 회사의 상표일 수 있다.